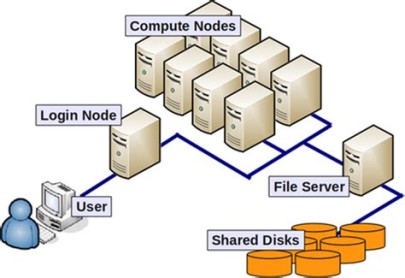

Zugang zum Cluster ist ausschließlich über die Login-Knoten und ausschließlich über ssh möglich.

Die Liste der verfügbaren Login-Knoten finden Sie hier.

Verwechseln Sie nicht die Login-Knoten mit dem gesamten HPC-Cluster!

Zur Nutzung des Clusters reicht es nicht aus, ein Programm nur einfach auf dem Login-Knoten zu starten.

Die Loginknoten sind nicht für „produktive“ bzw. lang andauernde Rechnungen gedacht!

Rechnerschlüssel

Das ssh-Protokoll verifiziert und authentifiziert nicht nur Personen, sondern stellt auch kryptografisch sicher, dass ein Rechner wirklich der ist, der er vorgibt zu sein. Das verhindert, dass sich eine manipulierte Maschine in böser Absicht als die ausgibt, die Sie eigentlich zu erreichen versuchen.

Jeder Rechner mit einem ssh-Server weist sich Ihnen gegenüber mit seinem host key aus, den Sie bei der ersten Verbindung mit einem neuen Rechner prüfen sollten.

Ihr lokaler ssh-Client zeigt Ihnen bei der ersten Verbindung zu einem Rechner dessen Host-Key-Fingerprint an und fragt, ob Sie diesen Host (-Key) wirklich akzeptieren wollen.

Sie sollten dort nur mit „yes“ antworten, nachdem Sie diesen Fingerprint mit dem hier unten aufgeführten verglichen haben – nur dann können Sie darauf vertrauen, dass Sie wirklich einen unserer Login-Knoten erreicht haben:

|

ED25519 (preferred, but other key types are also allowed – the once popular RSA Keys are not accepted anymore – see below for more details) |

Public Key | AAAAC3NzaC1lZDI1NTE5AAAAILTlBfX7g8HAbMy7x7vSS66HO6QtEItNByqtSkRUZauo |

| Fingerprint | SHA256:sCfHqKOHUK45d7XaHyWN/N8cTUd8Nh6o6T1ngNhbQa8 |

Aufgrund von Sicherheitsempfehlungen des BSI (TR-02102-1) sind ssh-Schlüssel auf Basis von RSA für das Lichtenberg-Cluster nicht mehr zugelassen.

Bitte nutzen Sie stattdessen den empfohlenen „ed25519“-Algorithmus.

Da die Loginnodes im öffentlichen und frei erreichbaren Internet stehen, müssen wir von Zeit zu Zeit (Sicherheits-) Updates installieren. Das geschieht ggf. kurzfristig (30 Minuten Vorwarnzeit). Rechnen Sie daher nicht mit einer dauerhaften Verfügbarkeit aller Loginnodes!

Verwendungszweck

Da sie allen Benutzern des Clusters zur Verfügung stehen müssen, sind sie nur für

- Vorbereiten und Abschicken von Jobs

- Datentransfers zum und vom Cluster (mittels scp, sftp oder rsync durch ssh)

- kurze Testläufe Ihrer Software (≤ 30 Minuten)

- Debugging von Programmen

- Statusabfragen Ihrer Jobs

zu nutzen. Prüfen Sie während Ihrer Testläufe auf einem Loginknoten mit „top“ oder „uptime“ dessen aktuelle CPU-Last, und reduzieren Sie sie durch Nutzung weniger Kerne/Threads/Prozesse oder zumindest mittels „nice“.

Vom Loginknoten aus werden die Rechenaufträge (=Jobs) mittels „sbatch“ in eine Warteschlange (=Queue) eingestellt. Dabei müssen die benötigten Ressourcen (zum Beispiel Speicherbedarf, Anzahl der Kerne, Dauer des Ressourcenbedarfs) angegeben werden.

Warteschlangensystem Slurm

Das Rechnen im Cluster wird über das Slurm-Batchsystem organisiert. Slurm berechnet, wann und auf welchen der Rechenknoten der Auftrag gestartet wird. Dabei werden unter anderem der Bedarf an Ressourcen, die Wartezeit des Auftrags und die Priorität des zugeordneten Projektes berücksichtigt.

Die Aufträge werden vom Batch-System auf einem (oder falls so angefordert, mehreren) der Rechenknoten gestartet.

Um den Rechenauftrag (=Job) an Slurm zu übergeben, wird ein Batch-Script benötigt. Dieses Script enthält die

- Anforderung an Ressourcen in Form von

#SBATCH …pragmas und - die Abfolge von Kommandos und Programmen, die die eigentliche wissenschaftliche Berechnung ausführen.

Das „Batch-Script“ (oder Jobscript) ist eine einfache Textdatei (mit UNIX-Zeilenenden!), die man am eigenen PC erzeugen und dann auf den Loginknoten übertragen kann. Unter Windows empfehlen wir dazu „Notepad++“, das man vor dem Speichern eines Batch-Scripts mittels „Bearbeiten“ – „Format Zeilenende“ auf UNIX (LF) umstellen muss.

Oder man legt das Script gleich mit UNIX-Editoren direkt auf dem Loginknoten an, womit man den o.a. potentiellen Ärger mit falschen Zeilenenden von vornherein vermeidet.